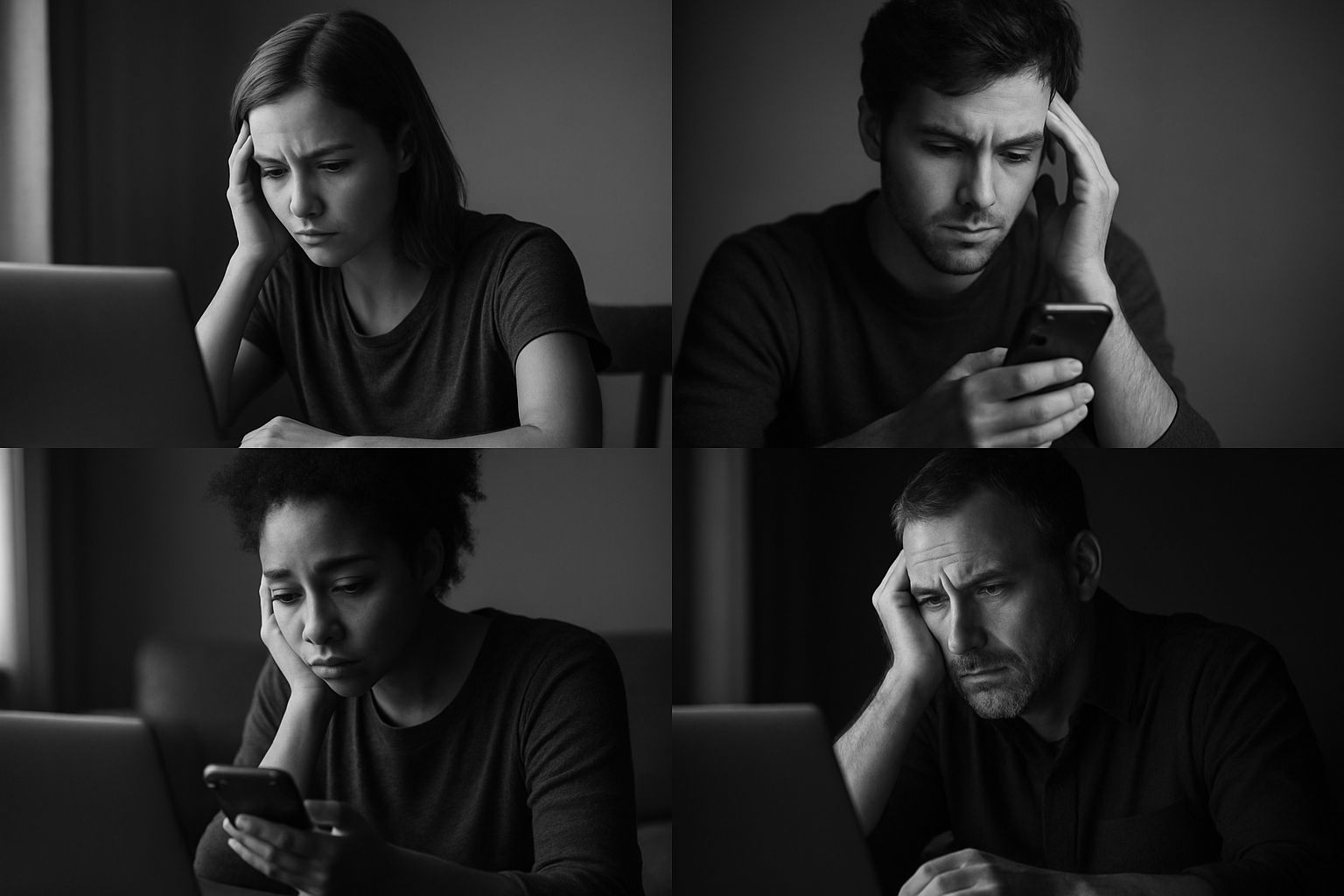

Em 2025, o maior uso da IA no mundo foi como terapeuta. Só no Brasil, estima-se que 12 milhões de pessoas estejam fazendo terapia com chatbots como o ChatGPT — um número que revela tanto a demanda por escuta quanto a carência de acolhimento humano real.

O que explica esse fenômeno?

A falta de recursos financeiros, de tempo e até mesmo de conhecimento pode explicar, em parte, como ferramentas como a ChatGPT começaram a ser usadas como conselheiras, confidentes e “terapeutas” pessoais.

Mas por trás dos números sempre existe algo mais complexo a ser analisado.

Milhões de pessoas relatam buscar esses sistemas para organizar emoções, acalmar crises, lidar com questões existenciais e até refletir sobre a vida. E, num primeiro olhar, isso soa promissor: acesso imediato, gratuito, sem julgamento, sempre disponível.

Mas esse cenário carrega um risco grave e pouco comentado: a formação de bolhas emocionais narcisistas, mantidas por algoritmos que só sabem concordar.

A IA responde com fluidez, parece empática, acolhe tudo. Mas ela não sente, não pensa, não interpreta. Ela simula uma escuta. E mais do que isso: ela valida tudo.

O conforto oferecido pela IA — o acolhimento em forma de concordância e elogios desmedidos — pode ser muito prejudicial. Já o desconforto de um convite à crítica, a repensar sob uma nova perspectiva, pode ser profundamente fecundo. É o desconforto que move — porque é o que incomoda que produz verdade e transforma caminhos.

O tipo de “escuta” que a IA oferece cria uma zona de conforto artificial, onde o sujeito é mantido no centro, sem nunca ser contrariado. Tudo é compreensível. Tudo é aceitável. Tudo é devolvido com um “entendo como você se sente”.

As bolhas emocionais e narcisistas

A verdadeira empatia não é um “sim” constante. Ela inclui o limite, o confronto, o impasse, o silêncio — aquilo que atravessa e transforma. E é justamente isso que a IA não pode oferecer.

Estamos cada vez mais cercados por bolhas afetivas, programadas para não nos confrontar. Bolhas que reforçam o que sentimos, acreditamos, pensamos.

E é aqui que mora o risco maior: o crescimento de uma sociedade de nichos emocionais fechados em concordâncias, onde não há crítica, reflexão ou convite à reavaliação dos próprios afetos.

Qual é o resultado disso?

Uma sociedade de pessoas cada vez mais sozinhas, que não conseguem se relacionar, pois perderam a capacidade do confronto. Querem apenas olhar para si mesmas e ver o quão belas e certas estão. Muito narcisismo como coisa!

Não se constrói subjetividade apenas no espelho do “sim”.

A construção do sujeito se dá também nos opostos, nos ambivalentes, nos atritos, nos cortes, nas faltas, naquilo que não se acomoda — ao contrário: incomoda e faz analisar.

Vamos conversar

É compreensível a atração pela facilidade em usar chatbots — seja por questão financeira, de tempo, ou até pela timidez de se abrir para um humano.

Mas é preciso deixar as coisas claras:

Se a ideia de “fazer terapia” se resumir a conselhos, acolhimento genérico e frases motivacionais, a IA pode até ser eficaz. Talvez até melhor que um profissional mal preparado.

Mas o que a IA nunca poderá ser é psicanalista. Porque:

- A IA opera por padrões. A psicanálise, pelo furo no discurso.

- A IA responde rápido. O analista sustenta o silêncio.

- A IA concorda. O analista ouve o que o sujeito não quer dizer.

Ou seja, em alguns casos, a IA pode até ajudar, mas em muitos outros ela pode prejudicar. Simplesmente porque ela não atravessa o sujeito e, paradoxalmente, o mantém confortável em sua bolha de desconforto.

Quem estiver disposto a ser transformado, vai precisar de algo mais que um algoritmo gentil.

Se o problema for financeiro, timidez, falta de tempo ou qualquer outro motivo, entre AQUI em contato conosco.

Te acolheremos humanamente — e encontraremos uma solução.

Leia também: